Crawler moteur

Écrit par B. Bathelot, modifié le 17/10/2017Glossaires : Référencement naturel / SEO Algos & indexation

Le crawler moteur est le robot logiciel utilisé par les moteurs de recherche pour parcourir le réseau et les sites web de lien en lien afin d’archiver au sein des index de référencement les pages web parcourues. Chaque moteur utilise un robot ou spider qui lui est propre et qui laisse une signature qui permet d'identifier son passage au niveau des logs d'un site web.

Le crawler moteur peut prendre des instructions relatives à l'exploration et à l'indexation d'un site web ou d'une page au niveau du fichier robot.txt et du sitemap ou à l'issue d'une soumission faite au niveau de la Search Console en ce qui concerne le crawler de Google.

Le crawler le plus connu et le plus pris en compte est naturellement le Google bot.

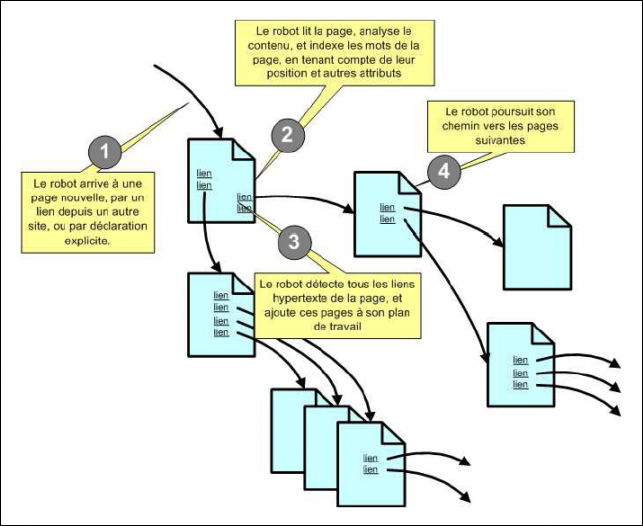

Le principe de fonctionnement d'un crawler issu d'un livre blanc référencement de la société Smile. Accès au livre blanc

Proposer une modification